인간처럼 '보고 듣고 말하고'를 한번에... 오픈AI, 옴니모델 GPT-4o 출시

[오픈AI 스프링 업데이트 이벤트] 최초의 옴니모델 등장

사람처럼 보고 듣고 말할 수 있는 인공지능

텍스트, 이미지, 음성 데이터를 동시에 입력해서 추론

실시간 통역도 자연스러워... 영상 보며 수학문제도 풀어

오픈AI가 13일 진행한 스프링 제품 업데이트 라이브 스트리밍 이벤트에서 GPT-4o라는 새로운 AI 모델을 발표했다. GPT-4o는 음성 인식과 스피치-투-텍스트 기능을 통합한 대화형 인터페이스 형태의 멀티모달 모델로, 실시간으로 자연스러운 상호작용이 가능하다. 또한, GPT-4 터보에 비해 2배 빠른 API를 제공한다. [AI요약 by 구버]

오픈AI는 13일(현지시각) 진행한 스프링 제품 업데이트 라이브 스트리밍 이벤트에서 새로운 AI 모델 GPT-4o를 공개했다.

GPT-4o는 음성 인식, 스피치-투-텍스트(Speech to text), 이미지 인식 기능 등이 통합돼 대화형 인터페이스 형태로 자연스러운 실시간 상호작용이 가능한 멀티모달(Multimodal, 다중 모드) 모델이다.

기존 GPT 모델이 프롬프트를 데스크톱이나 모바일을 통해 글자(텍스트)를 입력하는 것에 그쳤다면 GPT-4o는 음성, 텍스트, 시각 등 다양한 인간의 활동을 입력, AI가 추론하고 그 결과를 거의 실시간으로 내놓을 수 있도록 한 것이다. GPT-4o의 o는 모든 것을 아우른다는 의미인 ‘옴니(omni)’에 따왔다.

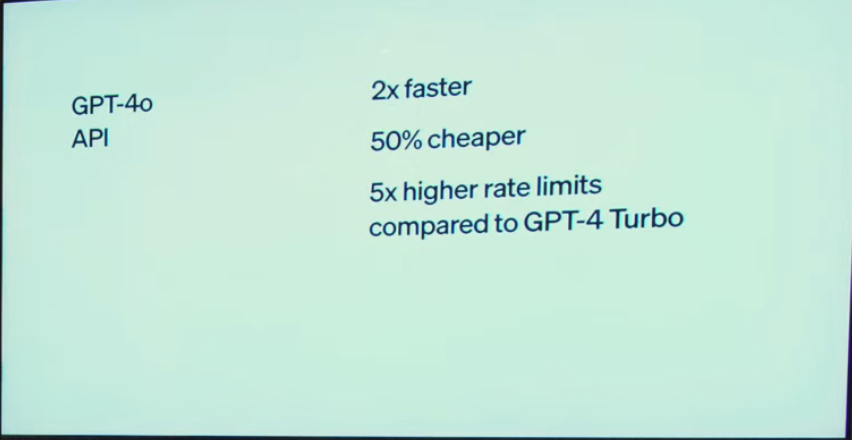

이날 발표는 샘 알트만 CEO가 아닌 미라 무라티 CTO(최고기술책임자)가 무대에 올라 주요 기능을 설명했다.발표를 맡은 무라티 오픈AI CTO는 “GPT-4o는 GPT-4 터보 대비 2배 빠른 API(애플리케이션 프로그래밍 인터페이스)를 제공한다”고 밝혔다. 전 세계 인구 97%가 사용하는 50개 언어를 지원하며 텍스트 및 이미지 기능은 무료로 사용할 수 있다.

GPT4o는 새로운 데스크톱 UI(사용자 인터페이스)를 통해 마치 '코파일럿' 처럼 작동할 수 있게 했다. 기존 GPT4 터보에 비해 2배 빠르고 50% 저렴하며 글자 제한도 5배나 높였다. 또 사람의 감정과 얼굴 표정도 인식하면서 현장에 참석한 오픈AI 직원들의 큰 박수를 받았다.

무라티 CTO는 “GPT-4o는 GPT-4 레벨의 지능을 더 빨리 제공한다"고 강조했다. 사람이 물흐르듯 대화하듯 빠른 반응을 내세운 것이다. 실제 GPT-4o의 평균 응답 시간은 232밀리초인데 이는 평균 320밀리초로 대답하는 인간과 비슷하다. GPT-3.5는 평균 2.8초의 응답 시간을, GPT-4가 5.4초였다.

GPT-4o의 특징

-무료 챗GPT 사용자에게도 텍스트 및 이미지 기능 제공

-다중 모드로 설계. 이미지, 텍스트 및 음성을 동시에 분석

-인간과 유사한 실시간 음성 상호작용을 지원. 말 끊기 가능

-음성 및 비전 기능을 갖춘 챗GPT 데스크톱 앱 출시

-향후 몇 주에 걸쳐 점진적으로 배포

AI, 인간처럼 보고 듣고 말하다

AI와 실시간 대화와 통역

GPT-4o의 가장 큰 업그레이드는 실시간 대화 기능이었다. 기존 챗GPT는 몇 초간 기다려야 하는 지연이 있었으나 GPT-4o는 음성으로 궁금한 것을 입력하면 실시간으로 음성 답변을 들을 수 있다.

GPT-4o는 대답이 자연스러울 뿐 아니라 심지어 감정까지 표현할 수 있었다. 잠잘 때 동화를 만들어달라는 요청부터 로봇 소리로 바꿔달라, 강렬한 드라마처럼 표현해달라는 요청에 즉각 반응했다.

실제 오픈AI 팀이 “로봇과 관련된 잠자리 동화를 들려줘”라고 말하자 즉시 동화를 만들어냈다. 연구원이 중간에 끊고 “아니, 좀 더 극적인 말투로 해줘”라고 요청하자 바로 성우처럼 감정을 추가한 말투로 동화를 읊었다.

또 실시간 '통역'도 시연했다. 오픈AI 팀은 실시간 통역 도구 역할을 하는 챗GPT 보이스의 기능을 시연했는데 미라 무라티가 이탈리아어로 얘기하면 영어로 변환한 다음 바로 영어로 응답을 받아 이탈리아어로 대화하는 높은 수준의 통번역 기능을 소개했다.

AI에 눈이 생겼다

AI가 스마트폰 카메라를 통해 대상을 해석하고 대답을 할 수 있게 됐다. 시연에서 오픈AI 팀은 종이에 실시간으로 작성한 수학 방정식을 GPT에 보여주고 AI에게 문제 해결을 도와달라고 요청했다.

오픈AI 팀은 챗GPT의 음성 대화 모드를 실행하고 “수학 문제를 풀건데 정답을 말하지 말고 풀이 과정을 도와줘”라고 요청했다. 이후 카메라를 실행시켜 화면에 ‘3x+1=4′라는 수식을 비춰주자, AI는 “x의 값을 구하기 위해선 x를 제외한 모든 숫자를 한쪽으로 모이게 해야한다. 저 1을 어떻게 해야할까?”라고 문제 풀이를 안내하는 모습을 보였다. 답을 주는 것이 아니라, 조언을 해주고 단계별로 문제를 풀어 나간 것이다.

또 연구원이 스마트폰 카메라로 웃고 있는 자신의 얼굴을 비추며 “내가 지금 어때보여”라고 묻자 챗GPT는 “기쁘고 신난 것 같다”고 대답하기도 했다. 오픈AI는 이날 시연을 마치고 공개한 웹사이트에 AI간에 대화를 주고 받는 데모 영상을 공개하기도 했다. AI가 "무엇이 보이냐?"고 묻자 다른 AI가 주변을 인식해 “검은 가죽 자켓을 입은 남성이 앉아있다”고 답했다.

코드와 그래프를 실시간으로 분석

GPT-4o는 작성 중인 코드를 보고 코드를 분석했다. 잠재적인 문제를 발견할 수 있었으며 현재 데스크톱에서 작업 중인 내용도 설명할 수 있었다. 데모 중에 그래프를 보고 실제 피드백과 정보를 제공하는 놀라운 장면을 연출했다.

언어 장벽을 더 낮춘다

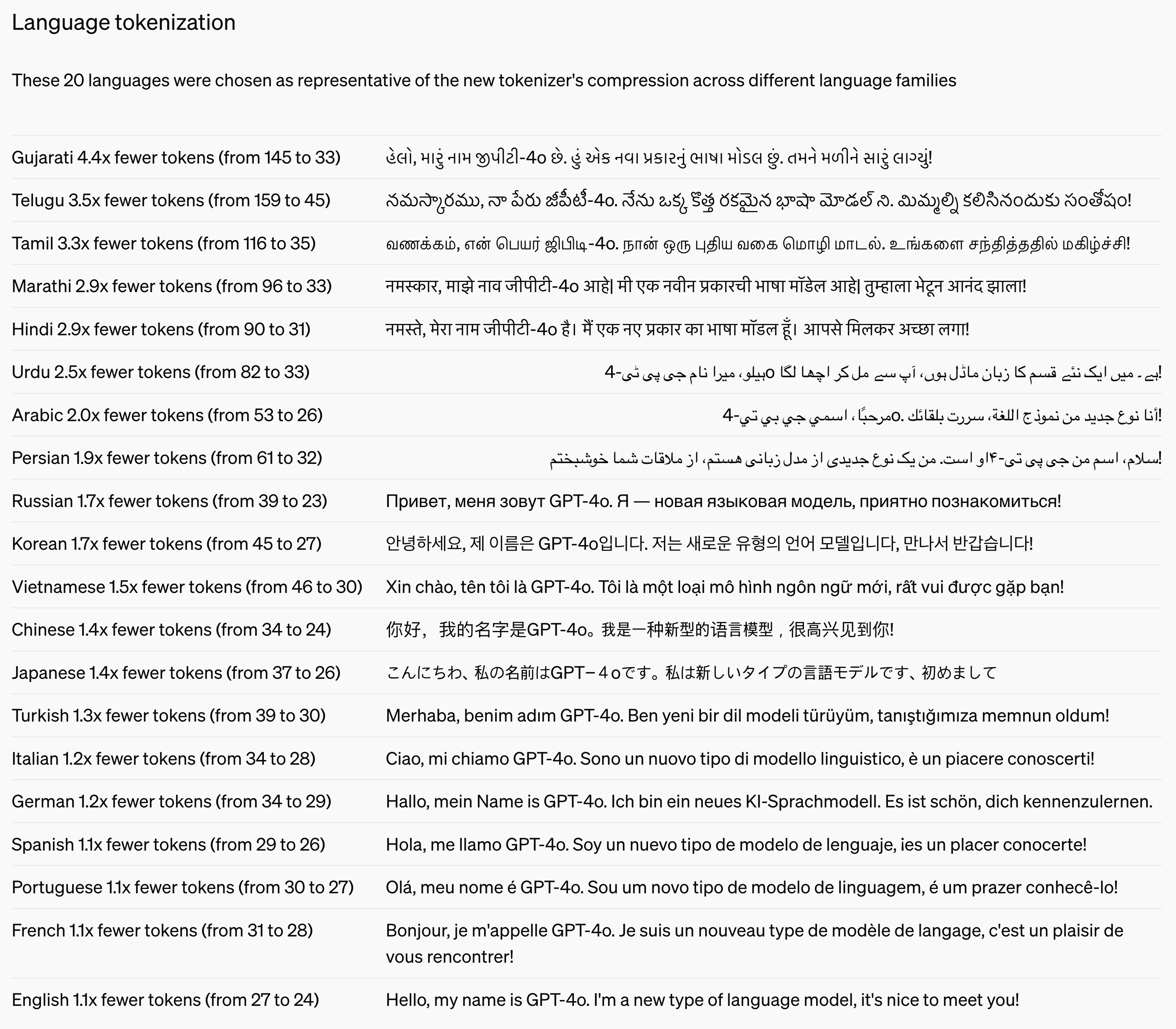

GPT-4o는 통역, 번역 기능이 우수하고 비영어권 언어의 성능과 토큰 효율을 크게 개선한 것이 특징이다.

오픈AI는 벤치마크 테스트를 공개하며 GPT-4o가 지난해 11월 출시된 'GPT-4 터보'와 동급 이상의 성능을 보여줬다. 제로샷 COT MMLU에선 88.7점으로 최고 성능을 기록했다. 한국어 등 비영어권 언어 성능과 토큰 효율도 개선했다.

예를 들어 '안녕하세요, 제 이름은 GPT-4o입니다. 저는 새로운 유형의 언어 모델입니다, 만나서 반갑습니다!' 라는 문장을 쓰면 문장에 기존에는 토큰 45개가 쓰였는데 27개로 줄었다. 1.7배 (70%) 개선됐다는게 오픈AI의 설명이다.

이번 글로벌 언어 업데이트엔 인도의 다양한 언어들에 대한 성는을 대폭 개선시켰다. 오픈AI가 인도 시장을 다음 타깃으로 삼고 있음을 시사하고 있다.

👉관련 기사: 애플 아이폰을 잡아라… ‘GPT-4o’발 지각변동 시작